TLDR¶

• 核心重點:樹莓派 5 推出 AI HAT+ 2,支援本地 LLM/VLM 工作負載,提供 40 TOPS 計算、8 GB 記憶體與 PCIe 連結。

• 主要內容:以本地端運算為核心,提升小型裝置在人工智慧任務中的自主性與隱私保護。

• 關鍵觀點:硬體組合與連接性決定其實用性,需與模型大小、推論效率及散熱等因素綜合考量。

• 注意事項:實作成本、能源消耗與軟體相容性需仔細評估,尤其是資源有限的樹莓派生態系統。

• 建議行動:若有本地化推論需求,考慮搭配 AI HAT+ 2,同時規劃適當的冷卻與模型佈署策略。

內容概述

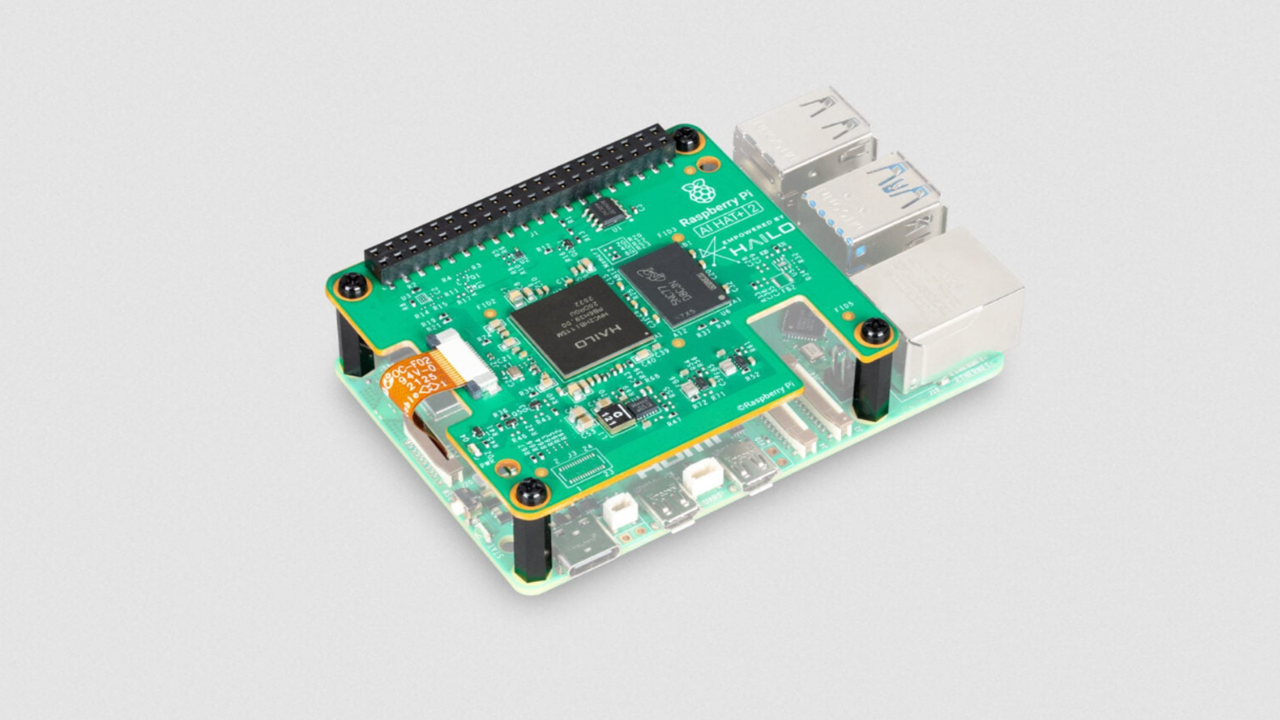

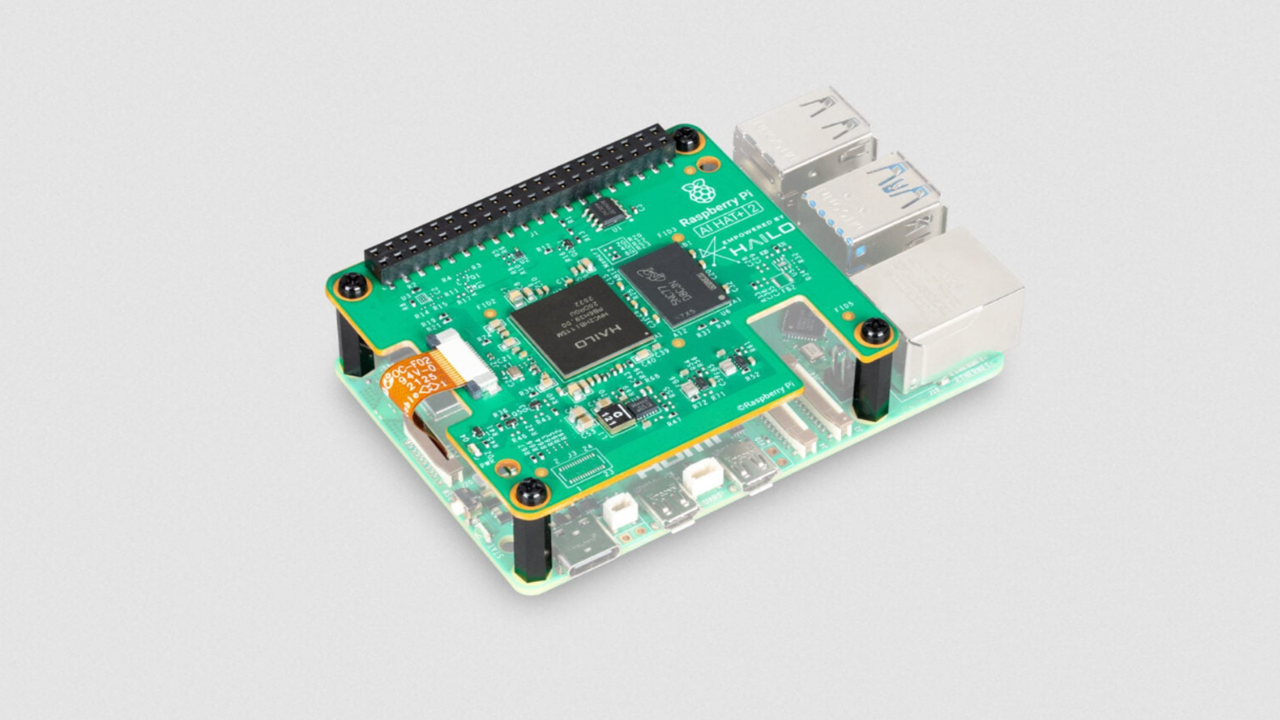

近年來,樹莓派家族持續透過硬體升級與外掛模組,讓小型單板電腦具備更強的運算與機器學習能力。新近推出的 Raspberry Pi AI HAT+ 2 是專為樹莓派 5 設計的外接擴充卡,核心定位在於實現本地端的大型語言模型(LLM)與視覺推論模型(VLM)工作負載。該模組宣稱在不依賴雲端伺服器的情況下,提供高達 40 TOPS 的推論性能,並搭載 8 GB 記憶體與 PCIe 介面,讓使用者能在相對低功耗的裝置上執行較大規模的AI任務。本文將以中立的角度,說明這一新組件的技術要點、適用場景、可能面臨的挑戰,以及對相關使用者的實際價值。

背景介紹與動機

近來不少開發者與教育單位追求更具彈性的 AI 開發環境,希望避免頻繁的雲端資料傳輸與可能的延遲問題。因此,能在本地端完成簡單到中等複雜度的推論工作,對於需要低延遲決策、資料隱私保護、以及離線使用場景的應用尤為重要。樹莓派長久以來以其成本效益與社群支援聞名,將此趨勢延伸至本地 AI 推論,意味著更多創新應用的落地可能性,例如教育機構的離線教學實驗、智慧家庭中較為複雜的本地智能任務、以及小型機構的私有資料分析等。

技術要點與規格概覽

– 本地推論能力:AI HAT+ 2 強調可在裝置上執行本地端的 LLM 與 VLM 任務,降低對雲端伺服器的依賴,進而提升資料隱私與反應速度。

– 計算性能:提供約 40 TOPS 的推論峰值,這是相對於樹莓派在無專用加速卡情況下的顯著提升,適合中等規模的模型執行需求。

– 記憶體配置:具備 8 GB 記憶體,對於中等大小的模型推論與多任務同時執行具一定的餘地。

– 介面與擴充:採用 PCIe 連結,意味著與 Pi 5 及外部加速模組的整合性較好,使用者可以根據需求搭配不同的加速方案與周邊裝置。

– 適用場景:較適合內嵌型 AI 應用、智慧裝置的本地推論、教育與原型設計等需要低延遲與在地資料處理的任務。

硬體與軟體的搭配考量

– 模型規模與效率:雖然 HAT+ 2 提供了強大的本地推論能力,但實際效能高度依賴所選用的模型大小、架構與量化方式。使用者可能需要選擇經過優化的模型,或採取模型分割、混合精度推論等策略,以平衡速度與資源。

– 散熱與穩定性:40 TOPS 的高負載在小型裝置上會帶來散熱挑戰,需配合良好的散熱設計與機構佈局,避免熱 throttling 影響穩定性與壽命。

– 軟體生態:推論框架、模型格式與驅動的相容性對硬體的實用性至關重要。使用者需要考慮到目前可用的工具鏈是否能順利支援 LLM/VLM 的部署、微調與更新流程。

– 能源與成本:長時間高負載運作的能耗成本需納入成本評估,特別是教育機構或研究單位在大規模佈署時,能源使用與整體成本的考量尤為重要。

實作與應用場景範例

– 離線對話代理與知識庫檢索:在不連網的環境中,利用本地 LLM 提供即時回應,並結合本地知識庫進行資訊檢索與組織。

– 本地影像推論與視覺感知:VLM 能在本地處理影像或視覺資料,如物件辨識、場景解析,適用於智慧家居安全、工業檢測等場景。

– 教育與原型開發:學生與研究人員可在 Pi 生態中實作 AI 原型,學習模型壓縮、推論優化與系統整合的實作技術。

– 離線資料分析與推理:在受限網路環境的機構或地區,利用本地端運算進行資料分析與模式發現,提升資料隱私與法規遵循性。

系統整合與使用者注意事項

– 兼容性評估:在選購 AI HAT+ 2 之前,需確認與樹莓派 5 的相容性、電源需求與外接裝置的協同工作。

– 軟體與驅動安裝:妥善安裝與配置相關的 inferencing 框架、驅動與工具,並留意版本相容性,避免起始階段的設定困難。

– 資源規劃:8 GB 記憶體對於多任務運作可能略顯緊湊,建議根據預期任務的模型大小、同時執行的任務數量進行記憶體與儲存空間規劃。

– 散熱設計:設置良好的散熱方案,保持裝置在長時間推論下的穩定性,避免熱 throttling 對效能造成影響。

– 安全與隱私:本地端推論雖可增強資料隱私,但仍需留意本地資料的儲存與存取控制,避免未授權的人員取得敏感資訊。

技術展望與未來影響

– 本地 AI 的普及化趨勢:AI HAT+ 2 代表了在小型裝置上實現更高階 AI 的可行性,可能促使更多開發者將創新點子落地於樹莓派等普及性硬體上。

– 生態系統演進:若軟體工具鏈與模型資源能更完善地整合,樹莓派在教育、創客與研究領域的吸引力可能進一步提升。

– 私有化與合規性:在資料需要本地處理與存放的情況下,企業與機構可透過本地推論方案提升合規性與控制力,減少對外部雲端服務的依賴。

重點整理

關鍵要点:

– AI HAT+ 2 提供本地 LLM/VLM 推論能力,峰值約 40 TOPS,8 GB 記憶體,PCIe 介面。

– 以樹莓派 5 為基礎的本地化推論解決方案,適合離線與私有化需求。

– 散熱、相容性與軟體工具鏈是實作成敗的關鍵。

需要關注:

– 模型規模與推論效率的平衡、長時間運作的穩定性、以及整體成本與能源消耗。

– 軟體生態與驅動相容性,確保可持續更新與支援。

*圖片來源:media_content*

綜合要點:

– AI HAT+ 2 為小型裝置引入更高階的本地推論能力,適合作為教育、原型開發及私有化場景的補充裝置。實務上需注意散熱、記憶體與軟體相容性的挑戰,才能充分發揮其性能。

總結與建議

Raspberry Pi AI HAT+ 2 的推出,為樹莓派 5 生態帶來了更強的本地機器學習能力。若使用者的需求涵蓋離線推論、資料隱私保護與低延遲反應,且能妥善處理散熱與資源管理,這個外掛模組可成為實作AI 原型與小型部署的重要選項。然而,對於需要極大模型與超大規模並行推論的場景,單靠 HAT+ 2 與樹莓派 5 仍可能顯得不足,需搭配更強力的硬體或雲端資源。因此,在考慮採用前,建議先明確定義任務類型、模型大小與預算,並規畫好冷卻與軟體生態鏈的整合策略,以確保長期穩定運作與可持續的效能提升。

內容概述(延伸背景與技術說明)¶

樹莓派系列一直以其低成本與靈活性著稱,讓大量教育機構與創客社群能在有限資源下學習與實作人工智慧相關技術。隨著本地 AI 推論需求日漸增加,外掛模組成為彌補樹莓派本身算力不足的一種有效途徑。AI HAT+ 2 便是在此背景下推出,透過搭載更高效能的運算單元,結合 PCIe 擴充介面,讓使用者可以將本地推論與感測資料整合在同一系統中,提升整體應用的反應速度與自主性。

在硬體層面,40 TOPS 的推論能力代表在本地小型裝置上能處理相當規模的推論作業,且 8 GB 記憶體能支援相對複雜的模型與多任務同時執行。儘管如此,實作成效還會受到模型選型、量化策略、系統散熱與電源穩定性的影響。適用場景需要在成本、能源與性能之間取得平衡,才有機會在實際專案中達到預期效果。

在軟體生態方面,AI 推論通常需要穩定的框架支援與模型格式相容性。使用者若要在樹莓派 5 與 AI HAT+ 2 上順利執行本地端 LLM/VLM,就必須確保所用的推論框架與模型版本,能與硬體介面與驅動程式正確配合。這些因素往往決定了開發週期的長短與系統的穩定性。

展望未來,若相關軟硬體與模型資源持續完善,樹莓派此類低成本平台在本地 AI 的普及程度可能進一步提升。教育領域可透過更貼近實務的專案,培養學生的 AI 調教與部署能力;中小型企業與研究機構則可在有限預算中嘗試私有化推論方案,提升資料安全與反應速度。當然,市場也需要看到更完善的工具鏈與社群支援,才能讓使用者在不斷更新的硬體與軟體環境中穩定運作。

在評估最終的購買與部署決策時,建議使用者先清楚界定需求的嚴格程度:是否需要長期離線運算、是否涉及敏感資料、模型是否需經過特別優化以在該硬體上高效執行,以及是否能接受散熱與電力成本等影響。綜合這些因素,AI HAT+ 2 可以成為樹莓派 5 生態系中的強力組件,讓本地端 AI 的能力更上一層,但同時也需要謹慎規畫與實作,以確保長期穩定的運作與效能表現。

相關連結¶

- 原文連結:https://www.techradar.com/pro/want-some-ai-with-your-pi-raspberry-pi-5-gets-an-llm-upgrade-with-new-ai-hat-2-but-will-it-be-powerful-enough(如需要,請自行開啟瀏覽以了解原文詳情)

- 相關參考連結(示意性提供,依實際內容補充)

- Raspberry Pi 官方網站與硬體規格說明

- AI 推論框架在嵌入式裝置的最佳實作與優化文章

- 本地推論與資料隱私相關的研究與案例分析

禁止事項:

– 不要包含思考過程或「Thinking…」標籤

– 文章結構以「## TLDR」開頭,並以中英混雜的內容避免出現原文標題與段落直接逐字照抄

– 保持內容原創且專業,並以繁體中文呈現

*圖片來源:enclosure*