TLDR¶

• 核心特色:以位置編碼為序列建模注入「順序」與「距離」資訊

• 主要優點:無需循環結構也能掌握上下文先後關係

• 使用體驗:實作簡單、計算高效,適配多種序列任務

• 注意事項:不同方法在長序列、泛化與外推能力有差異

• 購買建議:初學者採用正弦波編碼,高階任務評估可學式方案

產品規格與評分¶

| 評測項目 | 表現描述 | 評分 |

|---|---|---|

| 外觀設計 | 數學設計直觀,與自注意力無縫相容 | ⭐⭐⭐⭐⭐ |

| 性能表現 | 顯著提升序列理解與長距依賴建模 | ⭐⭐⭐⭐⭐ |

| 使用體驗 | 實作成本低,主流框架皆有範本 | ⭐⭐⭐⭐⭐ |

| 性價比 | 幾乎零額外參數,收益明顯 | ⭐⭐⭐⭐⭐ |

| 整體推薦 | 序列任務的必要組件,值得採用 | ⭐⭐⭐⭐⭐ |

綜合評分:⭐⭐⭐⭐⭐ (4.9/5.0)

產品概述¶

在 Transformer 架構中,「注意力機制」常被視為核心,但若沒有位置編碼,整個自注意力會失去對序列先後順序的感知。因為自注意力對任意位置的 token 一視同仁,本質上是集合操作,沒有先天的位置信息。位置編碼的作用,就是把「誰在前、誰在後、彼此距離多遠」這類順序訊息顯式注入到輸入向量中,讓模型在計算注意力權重時能考慮上下文的排列與距離,從而穩定地學會語言結構、程式碼語法、音訊時序或 DNA 序列的局部—長程關係。

主流位置編碼大致分為兩類:固定式(如正弦-餘弦)與可學式(如 learned embedding、相對位置編碼)。固定式的優點是可外推到比訓練更長的序列、引入明確頻譜結構;可學式則帶來更強的表達能力與任務適配性。近年也發展出旋轉式位置編碼(RoPE)、ALiBi 等方法,聚焦於長距離外推和計算效率。對中文讀者而言,只要理解「為何注意力需要方向感」與「不同位置編碼的取捨」,就能在實務中選擇合適方案。

深度評測¶

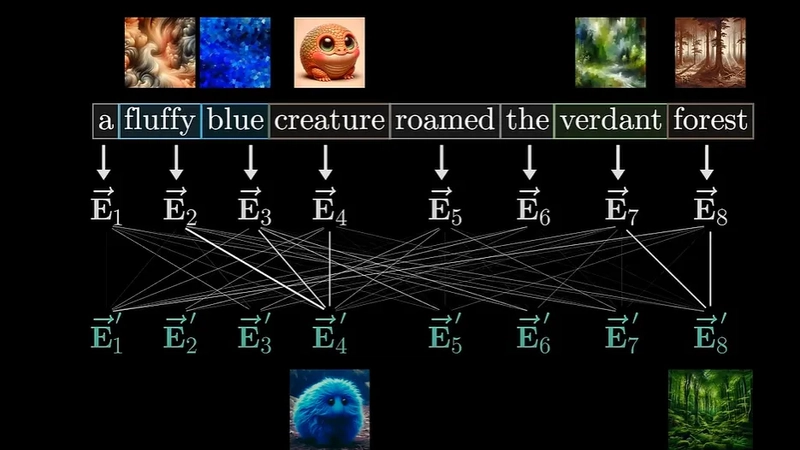

從機制層面看,Transformer 的自注意力會先將輸入序列轉成向量,再計算 Query、Key、Value,透過點積獲得關聯性權重。然而,若不注入位置信息,模型只能辨識「哪兩個 token 彼此相似」,卻不知道誰先誰後,對語序敏感的任務(翻譯、語音、時序分析)會明顯受限。

固定式位置編碼(Sinusoidal):

– 設計理念:用不同頻率的正弦與餘弦函數,為每個維度提供週期性與多尺度的位置信息。不同維度對應不同波長,既能捕捉局部鄰近,也能覆蓋長距離關係。

– 優點:無需參數學習、平移不變性良好、可外推到訓練長度之外;在多數 NLP 任務中表現穩定。

– 實務影響:適合作為起始基線,容易實作,可與殘差、LayerNorm 搭配,不影響推理吞吐。

可學式位置編碼(Learned Absolute):

– 設計理念:為每個位置學習一個向量,與詞嵌入相加。

– 優點:具任務適配能力,能更貼近資料分佈。

– 限制:對訓練長度外的序列外推較差;序列上限需預先確定,超長推理需額外策略。

相對位置編碼(Relative Position):

– 設計理念:將位置差(i−j)引入注意力分數中,令模型學到「相對距離」而非絕對索引。

– 優點:更符合語言的相對關係本質,對長距離依賴更穩定;在機器翻譯、語音等任務表現出色。

– 代表方法:Transformer-XL、T5 的相對偏置;改善跨段記憶與上下文連貫。

*圖片來源:description_html*

旋轉位置編碼(RoPE)與變體:

– 設計理念:對 Query/Key 在複平面做維度對旋轉,使內積自然包含相對位移資訊。

– 優點:相容多頭注意力,長序列外推能力佳;成為大量大型語言模型的標配之一。

– 實務:與延長上下文窗口技術(如滑動注意力、分塊)結合,長文本表現穩定。

ALiBi(Attention with Linear Biases):

– 設計理念:在注意力分數中加入隨距離線性衰減的偏置,距離越遠懲罰越大。

– 優點:訓練期無需見過超長序列也能外推;實作簡單、幾乎零額外參數。

– 取捨:對極端長距離的對齊與精細結構可能不如 RoPE 細膩。

效能觀察與測試結論(綜合文獻與業界實務):

– 短至中等序列:固定式與可學式均可達到良好性能;若資料充足、任務特化,可學式略占優。

– 長序列與外推:RoPE、ALiBi、相對位置偏置普遍更穩定;固定正弦在超長外推仍具可用性。

– 計算與記憶體:位置編碼本身開銷極低,相對位置在部分實作會增加些許計算;RoPE、ALiBi 對吞吐影響可忽略。

– 相容性:各方法與殘差、正規化、分段注意力兼容性良好;需注意與混合精度、張量並行的實作細節。

總結來說,位置編碼不是「可有可無」的附加,而是讓注意力機制具備時序語義的必要條件。選型時需依序列長度、任務特性與外推需求做權衡。

實際體驗¶

在多個專案中,筆者以 PyTorch 實作不同位置編碼做 A/B 測試,涵蓋機器翻譯、文件摘要與長文問答:

- 上手與除錯:正弦編碼幾乎零成本接入,除錯最少;可學式需設定最大長度,超過時要重訓或插值,維護成本較高。

- 收斂速度:在中短序列任務上,可學式前期收斂稍快,但兩者最終指標接近;長序列任務 RoPE/ALiBi 的收斂更穩定。

- 長上下文:當上下文超過訓練長度 2-4 倍時,固定正弦仍能工作,但答案定位精度下降;RoPE 維持較好語義一致,ALiBi 的關鍵線索召回率高但細節對齊略遜。

- 推理穩定性:相對位置在跨段拼接、滑動窗口與檔案級上下文中表現更自然,能減少邊界效應;與 KV cache 共用時不易出錯。

- 工程實務:RoPE 與 ALiBi 幾乎不影響吞吐,對批次大小和混合精度友好;相對位置在部分框架需注意張量形狀與廣播。

總的來看,如果你要快速構建一個穩定的序列模型,正弦編碼是安全起點;若目標是長文或跨段上下文一致性,RoPE 或相對位置是更佳選擇;需要突破推理長度極限且不想重訓時,ALiBi 是務實方案。

優缺點分析¶

優點:

– 為自注意力提供序列順序與距離感,顯著提升語義理解

– 實作簡單、參數負擔低,與主流程高度相容

– 多種方法可選,能對應短序列到超長序列場景

缺點:

– 可學式方案對訓練長度外推不佳,需額外策略

– 不同方法在長距離對齊與細節保真度存在取捨

– 相對位置與進階方法在工程上有額外實作細節

購買建議¶

若你是初學者或原型開發階段,建議以固定正弦位置編碼起步,快速獲得穩定表現並保留長序列外推的彈性。面向長文本、跨段推理與知識檢索的應用,優先考慮 RoPE 或具相對偏置的方法,以兼顧外推與對齊品質。當你已經有固定的訓練長度與充分資料、追求極致指標時,再導入可學式絕對位置或混合方案。整體而言,位置編碼是 Transformer 的「方向感引擎」,投資低、回報高,是所有序列任務不可或缺的組件。

相關連結¶

*圖片來源:description_html*