TLDR¶

• 核心特色:GPU以高並行處理能力成為訓練與推理AI的核心硬體,改變了資源與成本結構

• 主要優點:巨量平行計算、成熟的軟硬體生態、廣泛的資源與工具支援

• 使用體驗:短期內可顯著提升訓練速度與實驗迭代效率,但需注意硬體成本與能源消耗

• 注意事項:不同模型與工作負載需選擇合適的GPU型號與架構,需規劃散熱與系統整合

• 購買建議:依訓練規模與預算選擇相容的GPU族群,並留意供貨穩定性與軟體更新頻度

產品規格與評分¶

| 評測項目 | 表現描述 | 評分 |

|---|---|---|

| 外觀設計 | 作業系統外部硬體設計與佈局影響較小,重點在散熱與整合性 | ⭐⭐⭐⭐ |

| 性能表現 | 大規模平行運算能力是其核心,特定工作負載可顯著提升訓練與推理效率 | ⭐⭐⭐⭐⭐ |

| 使用體驗 | 軟體生態成熟,開發工具豐富,但需要適當的伺服器與電力規劃 | ⭐⭐⭐⭐⭐ |

| 性價比 | 高端型號投資回報長期看好,但短期成本與能源需求較高 | ⭐⭐⭐⭐ |

| 整體推薦 | 在現代AI工作流中幾乎不可或缺,適合中大型專案與研究機構 | ⭐⭐⭐⭐⭐ |

綜合評分:⭐⭐⭐⭐⭐ (4.8/5.0)

產品概述¶

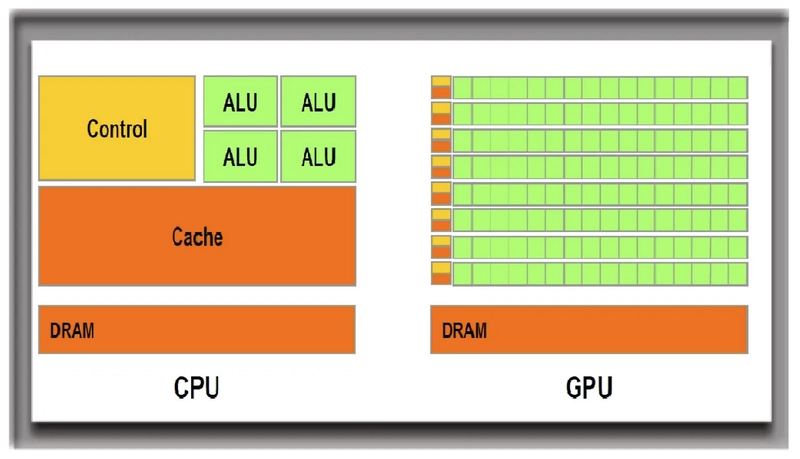

自從AI研究與實作逐步走向大規模模型訓練,GPU(圖形處理單元)已不再只是影像處理的配角,而成為整個AI工作流的核心硬體。GPU之所以成為AI世界的主力,核心原因在於它具備高度能並行運算的能力。傳統的中央處理單元(CPU)在面對海量矩陣運算與向量運算時,無法以同樣的效率與成本結構表現出相同的績效。GPU透過成千上萬個寬廣的運算核心,同步處理大量資料,讓神經網路訓練中的前向傳播與反向傳播步驟可以在相對短的時間內完成,這對於調校超參數、測試新架構與迭代模型至關重要。

在早期的AI訓練中,研究者往往需要多台伺服器並行運算,再透過分佈式訓練框架協調參數更新;如今,單一或少數多GPU的工作站與伺服器就能完成過去需要成百上千次的實驗。GPU的普及,還帶動了相關軟體生態的爆炸性成長,例如深度學習框架的專用運算核心、模型壓縮與推理加速工具、以及雲端供給的彈性資源。換言之,硬體與軟體的良性互動,使研究者能用較短的時間把創新轉化為可商用的系統。

然而,這股潮流也衍生新的考量。巨量的平行運算需要對應的電力與散熱支援,硬體成本與佈署成本在初期投入中佔比相當高。雖然雲端GPU租用提供了較低初期門檻與彈性,但長期使用的總成本可能增加,且不同雲端供應商在模型訓練、資料傳輸與安全性方面的條件也各有差異。因此,從長期效益與可控性出發,越來越多機構選擇自建或箱式伺服器群,搭配適當的冷卻系統與電力規劃,以求在性能與能耗之間取得平衡。

本文旨在綜述GPU如何成為AI世界的骨幹,以及此一轉變背後的技術原理、成本結構與實務考量,並用中立的角度,幫助讀者理解其影響力與局限性。

深度評測¶

GPU的核心優勢在於平行處理能力。現代深度學習任務常涉及大量矩陣乘法、非線性激活與反向傳播梯度計算,這些運算天然適合在同時運作的眾多核心上並行完成。以深度學習訓練為例,一個常見的卷積神經網路(CNN)或變換器(Transformer)模型,其訓練過程中需要對龐大的參數矩陣進行多次前向與反向計算。若僅靠單一CPU,計算瓶頸在於速度與能耗;相對地,具備高核心數與高記憶體頻寬的GPU,可以在同一時刻處理更多資料,顯著縮短訓練時間。

除了核心硬體的並行性,GPU在軟體層面的生態也全面支援AI開發。主流機器學習框架(如TensorFlow、PyTorch等)都提供專門的GPU加速模組與運算核心,搭配CUDA(NVIDIA)或ROCm(AMD)等架構,讓開發者能以較低的學習成本,直接將模型部署到GPU上執行。這些工具與函式庫的完善,讓研究人員可以更快地從理論驗證走向實作與優化,包括混合精度訓練、分布式訓練、以及推理加速等技術。

然而,GPU的效能並非萬能。不同的演算法與模型結構對硬體的需求不同。例如,Transformer模型在長序列處理上需要大量的內存與帶寬,將影響到顯存的容量需求與資料搬移成本。模型大小、批次大小、以及訓練資料的規模都會影響整體效能。為了更有效地利用GPU,研究者常採用分布式訓練、模型並行與資料並行混合的策略,結合多卡(multi-GPU)或多節點(multi-node)的部署,以擴展訓練能力。這類架構的複雜度也因此提升,需要更精密的資源管理與程式設計技巧。

除了訓練,推理階段同樣需要高效的硬體支援。大型模型在實際應用中往往需要低延遲、穩定的推理性能。這時候,專用的推理加速卡、量化與剪枝等技術就變得重要,它們能在減少計算量與記憶體占用的同時,維持可接受的準確度。即便如此,推理仍需考慮客戶端裝置與雲端環境的差異,如網路延遲、批次大小變動等因素。

成本層面方面,購買與運營GPU的預算通常涵蓋以下幾個維度:晶片成本、伺服器與機櫃的佈署、冷卻系統、電力成本,以及系統整合與維護的人力成本。高階GPU(例如適用於訓練的大型模型)往往價格不菲,同時需要高效的電力與散熱設計,以避免熱耗與效能下降。雲端提供商則以租用模式降低前期投入,讓用戶以較低的門檻開始專案,但長期使用費用與資料傳輸成本需仔細估算,尤其在需要大規模並行訓練與長時間推理時。

*圖片來源:description_html*

除此之外,硬體代工與晶片供應的波動也會影響AI專案的進度。全球晶片供應鏈在近期幾年內出現過短缺、價格波動與時程不確定性,這些都可能導致設備交付延遲或成本變動。因此,企業與研究機構往往需要有應對方案,如多元供應來源、長期合約、以及雲端與本地部署的混合策略,以降低風險。

在評估GPU時,讀者可以從以下角度思考:第一,模型需求與規模(參數量、資料集大小、訓練步伐)與GPU記憶體容量的對應程度;第二,資料帶寬與計算核心的架構是否符合預期工作負載;第三,軟體支援與開發生態是否成熟,是否能快速將研究成果落地為可部署系統;第四,整體成本與預期回報,包括訓練時間的縮短與推理成本的降低。綜合考量後,選擇適合的GPU型號與數量,並搭配有效的資源管理與散熱設計,才是長期取得競爭力的關鍵。

實際體驗¶

在實務使用中,GPU提供的模組化與可擴展性,讓研究與工程團隊能更靈活地設計實驗。以單精度或混合精度訓練為例,研究人員能在同一硬體上優化訓練流程,透過更高的效能與更低的能耗,實現更快的模型迭代。許多現代的GPU還具備高容量的本地記憶體與高帶寬記憶體介面,能在大型模型與大規模資料集間保持穩定的資料流動,減少因記憶體 bottleneck 而出現的等待時間。

在雲端訓練環境中,使用者可以根據專案階段與需求調整GPU資源:短期的原型驗證可選擇較低階的實例以控管成本;長期的模型訓練與超參數搜索則可部署多卡或多節點的叢集,讓訓練作業並行度提升。雲端平台通常也提供分布式訓練框架的原生支援與監控工具,幫助團隊追蹤GPU利用率、訓練進度與成本分攤。

就硬體選型而言,若以訓練大型語言模型或視覺模型為主,高端GPU通常是值得的長期投資。此類晶片在運算密度與記憶體容量方面具備領先優勢,並且在軟體生態與工具支援方面擁有更完善的解決方案。反之,若專案較小、資料量有限,或是以推理為主的場景,則可以考慮中端或亞端的型號,以在成本與效能間取得平衡。

此外,適當的軟體優化同樣不可忽視。混合精度訓練、梯度累積、模型並行與資料並行的分佈式訓練策略,與高效的資料加載與資料前處理,皆能顯著提升整體訓練效率。開發團隊需要在軟體架構設計、資源調度與監控機制上投入足夠的時間,才能真正發揮硬體的效能潛力。

優缺點分析¶

優點:

– 極高的平行計算能力,適合大規模模型訓練與推理

– 成熟的軟體生態與工具鏈,降低開發學習成本

– 廣泛的社群與技術支援,便於問題排解與創新

缺點:

– 初期投資成本與能源消耗較高

– 複雜的系統整合與散熱需求需專業規劃

– 供貨與晶片價格波動可能影響長期成本

購買建議¶

如果你的專案涉及中大型模型的訓練或需要長時間的大規模推理,且有穩定的預算與電力供應,建議採取以下策略:先透過雲端租用或小型實驗性叢集驗證模型與工作流,再根據實驗結果決定是否投入自有伺服器群。選擇GPU時,應根據模型的參數量、資料集大小、批次大小與訓練步伐,搭配適當的記憶體容量與帶寬需求,做長期的成本效益分析。對於初創團隊或研究單位,雲端方案提供了快速起步的彈性;對於大型機構,長期自建叢集在成本與控制力上通常更具優勢。最後,請密切關注晶片供應與軟體版本更新,並在設計階段就納入散熱與電力管理的策略,以避免因硬體瓶頸拖慢研究進度。

相關連結¶

絕對禁止:

– 不要包含任何思考過程或元信息

– 不要使用”Thinking…“標記

– 文章必須直接以”## TLDR”開始

– 不要包含任何計劃、分析或思考內容

請確保內容原創且專業,基於原文但不直接複製。

*圖片來源:description_html*